Die AI von Android P wird Ihr Leben vereinfachen, benötigt aber noch mehr Daten

Google hat skizziert, was wir von Android P auf der I/O 2018, seiner jährlichen Entwicklerkonferenz, erwarten können. Wie üblich wurden die neuen 2018 Pixel-Handys jedoch nicht gleichzeitig vorgestellt. Es gibt ein paar kleine Hinweise, wie die neue Telefon-Hardware aussehen könnte. Aber wie Google beabsichtigt, Android P-Handys in Zukunft zu nutzen, ist viel interessanter.

Der Google Assistant AI wird mehr denn je an die Oberfläche gedrückt. Es wird unsere Telefone nützlicher machen, und wahrscheinlich besser bei der Erstellung eines detaillierten Profils über jeden von uns. Android P rät, was wir als nächstes tun wollen, und wird sogar vorschlagen, wann wir vielleicht YouTube und Facebook entlassen, wie der Betrunkene in einer Bar, der einen zu viel hatte.

Was ist mit den Telefonen?

Was sagt Android P über die nächsten Pixel-Handys, bevor wir uns mit den Funktionen beschäftigen? Es gibt nichts Bestimmtes, aber Google sagt, dass der neue Ein-Knopf-Softkey der Software für Telefone mit sehr wenig Platz unter dem Display entwickelt wurde.

Telefonhersteller haben sich an der unteren „Lippe“ von Handys mit 18:9 bis 19:9 extra langen Bildschirmen abgeplatzt. Der neue virtuelle Softkey lässt tatsächlich mehr Platz zwischen sich und den App Dock Icons, um das zu kompensieren. Der Pixel 3 wird mit ziemlicher Sicherheit einen sehr langen Bildschirm haben. Wie jedes andere High-End-Telefon der letzten Zeit. Keine Überraschungen hier.

Es gibt auch einen viel lockereren Vorschlag, dass der nächste Pixel zwei Kameras haben könnte. Das kommt durch einen viel größeren Augmented Reality-Einfluss in Android.

Sie werden bald in der Lage sein, die reale Kameraansicht auf Google Maps zu sehen. Es wird verwendet, um visuelle Richtungen auf tatsächlichen Straßen zu zeigen, anstatt sich auf Sprachansagen und schriftliche Anweisungen zu verlassen. Google zeigte sogar ein AR-Tier, das anstelle eines Pfeils eine Straße hinunter verschwand und signalisierte, wohin es gehen sollte.

Dies ist eine vollständige Augmented Reality, die eine ziemlich detaillierte Tiefenkarte einer Szene erfordert. Und das funktioniert am besten entweder mit Doppelkameras, die den Parallaxeneffekt zur Entfernungsberechnung nutzen, oder mit einem Infrarot-Array.

Google hat bewiesen, dass es auch nicht nötig ist. Es hat bereits erfolgreich AR-Erfahrungen mit einer einzigen Kamera gemacht und eine Tiefenkarte erstellt, wenn die Kamera bewegt wird, basierend auf dem gleichen visuellen Effekt, den eine Dual-Kamera-Array-Monitore im Stillstand haben. Wenn Google feststellt, dass es mit zwei Augen bessere Ergebnisse erzielt, kann es eine zweite Kamera auf der Rückseite des Pixel 3 platzieren. Bisher hatten alle Pixel-Handys eine einzige Hauptkamera. Welche Option auch immer Google wählt, das Pixel 3 wird wahrscheinlich zu den besten Smartphones gehören, die dieses Jahr veröffentlicht werden.

Eine geführte Erfahrung

AR Google Maps Richtungen sind nur eine Möglichkeit, die nächste Welle von Android-Updates führt uns durch den Alltag mit Smartphones. Einige andere sind fast unsichtbar.

Adaptive Auto Brightness lernt, wie Sie die Helligkeit Ihres Telefons nach oben und unten erhöhen und so eine neue automatische Helligkeitskurve basierend auf Ihrem Verhalten erstellen. Die Helligkeit in Innenräumen reduzieren, auch wenn Sie den Auto-Modus verwenden? Android P stellt die automatische Helligkeit neu ein, um dies zu berücksichtigen.

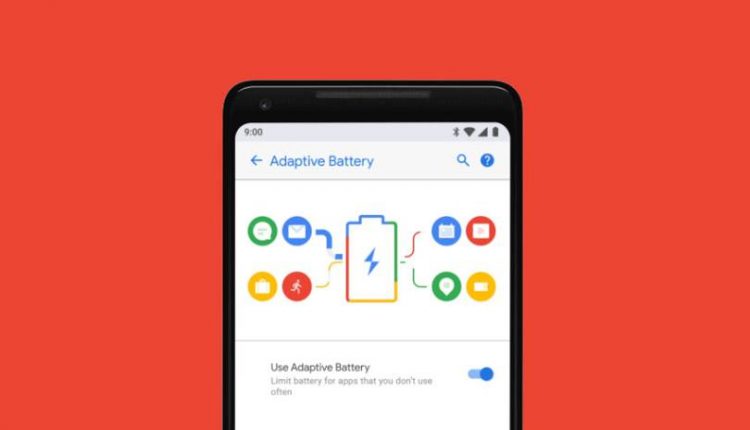

Eine weitere unsichtbare Neuerung ist die adaptive Batterie. Dies überwacht, wie Sie Anwendungen verwenden und schränkt die Hintergrundprozesse derjenigen ein, von denen es glaubt, dass Sie keine Pläne zur Verwendung haben. Wenn Sie die App A nur abends benutzen, kann sie z.B. mit der adaptiven Batterie morgens keine Hintergrundprozesse starten. Google sagt, es reduziert „CPU-Wakeups“ um 30 Prozent, was die Akkulaufzeit für diejenigen, die ihr Handy nicht so oft benutzen, drastisch verbessern könnte.

Google-Assistent wird seltsam

Dies ist auch ein Grund, warum Google möchte, dass wir die Assistant AI wie eine Person behandeln und nicht wie eine intelligentere automatisierte Telefonleitung. Je weniger wir bei einer Anfrage die Einschränkungen eines Assistenten berücksichtigen müssen, desto wahrscheinlicher ist es, dass wir sie nutzen. Mit jeder Anfrage füttern wir Google-Daten.

In den „kommenden Wochen“ werden wir in der Lage sein, mehrere tangential zusammenhängende Assistentenanfragen in einem Satz zu stellen. Es ist eine wirklich beeindruckende technische Leistung. Und Google wird den Betrag, den wir haben, um zu sagen, das Rütteln „Ok, Google“ Wake Word.

Es kommen auch sehr merkwürdige Dinge zu Assistant. Bald können Sie damit Orte wie Restaurants und Friseure anrufen. Du wirst den Anruf nicht machen. Es wird, im Hintergrund, nachdem Sie es bitten, einen Termin zu vereinbaren oder zu buchen. Dies wird als Google Duplex bezeichnet.

Google hat uns einige scheinbar echte Testanrufe vorgespielt. Die eine war eine einfache Buchung in einem Friseursalon, die andere ein unangenehmeres Gespräch mit einem lokalen Restaurant. Der Besitzer hat einige der Sätze des Assistenten missverstanden, aber die KI hat es trotzdem geschafft, mit überzeugenden Antworten zurückzukommen und den Anruf erfolgreich abzuschließen.

Ein interessanter Punkt: Diese Anrufe scheinen nicht die gleichen Stimmen oder Techniken wie der Google-Assistent zu verwenden. Stattdessen verwenden sie naturalistischere Phrasen mit Pausen „umm „s, Pausen und was eher wie vorab aufgenommene Phrasen klingt als vollsynthetisierte Sprachclips.

Google wird auch den Assistenten hinzufügen, so dass Sie aus sechs Stimmen wählen können. Sänger John Legend hat sogar Zeit damit verbracht, Stimmproben für Assistant aufzunehmen, und seine sanften Töne werden für bestimmte Assistenten-Antworten verfügbar sein. Es ist ein Versuch, den Assistenten mehr Spaß zu machen, wie z.B. benutzerdefinierte Stimmen für ein GPS-Gerät im Auto.